In den letzten Monaten wurde die Gemeinschaft der künstlichen Intelligenz von einer hitzigen Debatte heimgesucht, die durch zwei einflussreiche, von Apple veröffentlichte Forschungsarbeiten ausgelöst wurde. Das erste, Illusion des Denkens - Die Debatte, die die Welt der KI erschüttert&_bhlid=a540c17e5de7c2723906dabd9b8f31cdf0c5bf18" target="_blank" id="">"GSM-Symbolic" (Oktober 2024), und das zweite, "Die Illusion des Denkens" (Juni 2025), stellten die angeblichen Denkfähigkeiten von Large Language Models in Frage und lösten in der Branche gemischte Reaktionen aus.

Wie bereits in unserer vorherigen Untersuchung zu „Die Illusion des Fortschritts: Allgemeine künstliche Intelligenz simulieren, ohne sie zu erreichen”, berührt die Frage des künstlichen Denkens den Kern dessen, was wir unter Intelligenz in Maschinen verstehen.

Apple-Forscher führten eine systematische Analyse von Large Reasoning Models (LRM) durch, d. h. von Modellen, die ausführliche Argumentationsspuren erzeugen, bevor sie eine Antwort geben. Die Ergebnisse waren überraschend und für viele alarmierend.

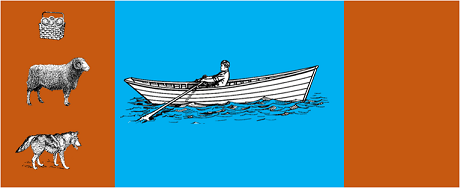

In der Studie wurden die fortschrittlichsten Modelle klassischen algorithmischen Rätseln unterzogen:

Die Ergebnisse zeigten, dass selbst kleine Änderungen in der Problemformulierung zu erheblichen Leistungsschwankungen führen, was auf eine besorgniserregende Schwäche des Denkens hindeutet. Wie berichtet in AppleInsider-Berichterstattungnimmt die Leistung aller Modelle ab, wenn nur die numerischen Werte in den GSM-Symbolic-Benchmark-Fragen geändert werden".

Die Antwort der KI-Gemeinschaft ließ nicht lange auf sich warten. Alex Lawsen von Open Philanthropy veröffentlichte in Zusammenarbeit mit Claude Opus von Anthropic eine ausführliche Gegendarstellung mit dem Titel "Die Illusion des Denkens'.in der er die Methodik und die Schlussfolgerungen der Apple-Studie anzweifelt.

Als Lawsen die Tests mit alternativen Methoden wiederholte - indem er die Modelle aufforderte, rekursive Funktionen zu erzeugen, anstatt alle Züge aufzulisten - waren die Ergebnisse dramatisch anders. Modelle wie Claude, gemini und GPT lösten Tower of Hanoi-Probleme mit 15 Datensätzen korrekt, weit jenseits der Komplexität, bei der Apple null Erfolge meldete.

Gary Marcusein langjähriger Kritiker der Denkfähigkeiten von LLMs, begrüßte die Ergebnisse von Apple als Bestätigung seiner 20-jährigen These. Marcus zufolge haben LLMs nach wie vor Probleme mit der "Verteilungsverschiebung" - der Fähigkeit, über die Trainingsdaten hinaus zu verallgemeinern - und sind gleichzeitig "gute Löser von Problemen, die bereits gelöst wurden".

Die Diskussion hat sich auch auf spezialisierte Gemeinschaften wie LocalLlama auf Redditwo Entwickler und Forscher über die praktischen Auswirkungen von Open-Source-Modellen und die lokale Umsetzung diskutieren.

Diese Debatte ist nicht rein akademisch. Sie hat direkte Auswirkungen auf:

Wie in mehreren Beiträgen hervorgehoben technischen Erkenntnissenhervorgehoben wurde, besteht ein zunehmender Bedarf an hybriden Ansätzen, die eine Kombination darstellen:

Triviales Beispiel: ein KI-Assistent, der bei der Buchhaltung hilft. Das Sprachmodell versteht, wenn Sie fragen: "Wie viel habe ich diesen Monat für Reisen ausgegeben?" und extrahiert die relevanten Parameter (Kategorie: Reisen, Zeitraum: diesen Monat). Aber die SQL-Abfrage, die die Datenbank abfragt, die Summe berechnet und die steuerlichen Beschränkungen überprüft? Das wird durch deterministischen Code erledigt, nicht durch das neuronale Modell.

Beobachtern ist nicht entgangen, dass das Apple-Papier kurz vor der WWDC veröffentlicht wurde, was Fragen nach den strategischen Beweggründen aufwirft. Wie dieAnalyse von 9to5Mac"Der Zeitpunkt der Veröffentlichung des Apple-Papiers - kurz vor der WWDC - hat einige Augenbrauen aufgeworfen. War dies ein Meilenstein in der Forschung oder ein strategischer Schritt, um Apple in der breiteren KI-Landschaft neu zu positionieren?"

Die durch die Apple-Papiere ausgelöste Debatte erinnert uns daran, dass wir uns beim Verständnis der künstlichen Intelligenz noch in einem frühen Stadium befinden. Wie wir in unserem früheren Artikelhingewiesen, bleibt die Unterscheidung zwischen Simulation und echtem Denken eine der komplexesten Herausforderungen unserer Zeit.

Die eigentliche Lektion ist nicht, ob LLMs im menschlichen Sinne "denken" können oder nicht, sondern vielmehr, wie wir Systeme entwickeln können, die ihre Stärken nutzen und gleichzeitig ihre Grenzen ausgleichen. In einer Welt, in der KI bereits ganze Sektoren umgestaltet, stellt sich nicht mehr die Frage, ob diese Werkzeuge "intelligent" sind, sondern wie man sie effektiv und verantwortungsvoll einsetzt.

Die Zukunft der KI im Unternehmen wird wahrscheinlich nicht in einem einzigen revolutionären Ansatz liegen, sondern in der intelligenten Orchestrierung mehrerer sich ergänzender Technologien. Und in diesem Szenario wird die Fähigkeit, die Fähigkeiten unserer Tools kritisch und ehrlich zu bewerten, selbst zu einem Wettbewerbsvorteil.

Neueste Entwicklungen (Januar 2026)

OpenAI veröffentlicht o3 und o4-mini: Am 16. April 2025 hat OpenAI o3 und o4-mini, die fortschrittlichsten Reasoning-Modelle der o-Serie, öffentlich vorgestellt. Diese Modelle können nun Tools auf agentenbasierte Weise nutzen und dabei Websuche, Dateianalyse, visuelles Denken und Bildgenerierung kombinieren. o3 hat neue Rekorde bei Benchmarks wie Codeforces, SWE-bench und MMMU aufgestellt, während o4-mini die Leistung und Kosten für umfangreiche Reasoning-Aufgaben optimiert. Die Modelle demonstrieren die Fähigkeit zum „Denken mit Bildern”, indem sie Inhalte für eine tiefergehende Analyse visuell transformieren.

DeepSeek-R1 revolutioniert die KI-Branche: Im Januar 2025 veröffentlichte DeepSeek R1, ein Open-Source-Modell für logisches Denken, das eine mit OpenAI o1 vergleichbare Leistung bei Trainingskosten von nur 6 Millionen US-Dollar (im Gegensatz zu Hunderten von Millionen bei westlichen Modellen) erzielte. DeepSeek-R1 beweist, dass Schlussfolgerungsfähigkeiten durch reines Reinforcement Learning gefördert werden können, ohne dass annotierte menschliche Demonstrationen erforderlich sind. Das Modell wurde in Dutzenden von Ländern zur kostenlosen App Nr. 1 im App Store und bei Google Play. Im Januar 2026 veröffentlichte DeepSeek ein 60-seitiges Papier, das die Geheimnisse des Trainings enthüllt und offen zugibt, dass Techniken wie Monte Carlo Tree Search (MCTS) für allgemeines Schlussfolgern nicht funktioniert haben.

Anthropic aktualisiert Claudes „Verfassung“: Am 22. Januar 2026 veröffentlichte Anthropic eine neue, 23.000 Wörter umfassende Verfassung für Claude, in der von einem regelbasierten Ansatz zu einem Ansatz übergegangen wird, der auf dem Verständnis ethischer Prinzipien basiert. Das Dokument ist das erste Rahmenwerk eines großen KI-Unternehmens, das die Möglichkeit eines Bewusstseins oder moralischen Status von KI formell anerkennt und bekräftigt, dass Anthropic sich um das „psychologische Wohlbefinden, Selbstbewusstsein und Wohlergehen” von Claude kümmert.

Die Debatte verschärft sich: Eine Studie vom Juli 2025 hat die Apple-Benchmarks wiederholt und verfeinert und bestätigt, dass LRM bei moderat steigender Komplexität (etwa 8 Scheiben im Turm von Hanoi) weiterhin kognitive Einschränkungen aufweisen. Die Forscher haben gezeigt, dass dies nicht nur auf Ausgabebeschränkungen zurückzuführen ist, sondern auch auf tatsächliche kognitive Grenzen, was deutlich macht, dass die Debatte noch lange nicht abgeschlossen ist.

Für Einblicke in die KI-Strategie Ihres Unternehmens und die Implementierung robuster Lösungen steht unser Expertenteam für maßgeschneiderte Beratungen zur Verfügung.